9 de julio de 2013

WINDOWS 8.1

Windows 8.1 o "Blue"

(Azul) es el nombre actual del sistema operativo para ordenadores y tabletas en

forma de actualización a Windows 8 (únicamente se encuentra en preview). Su

lanzamiento oficial será en Noviembre de 2013.

Este proyecto es un cambio con

respecto a la política tradicional de actualizaciones de Microsoft, que

originalmente consistía en lanzamientos regulares de "Service Packs"

cada 2 años aproximadamente, ya que será una actualización mayor que

introducirá varias mejoras en todas las plataformas de Microsoft incluyendo

Windows 8, Windows Phone 8 y Windows RT.

Microsoft notifica que la

actualización está disponible en Preview para descargar en la Tienda de Windows

8. Estará disponible gratuitamente para usuarios con licencia original de

Windows 8 por medio de descarga en la tienda oficial, su fecha concreta de

lanzamiento es en Noviembre de 2013

En Windows 8 se han introducido nuevas aplicaciones.

Fotos

Vídeo

Música

Xbox Music

Calendario

Mensajes

Contactos

Mapas

Windows Store

Cámara

SkyDrive App

Noticias

Deportes

Viajes

Bing App

Windows 8.1 Preview funciona correctamente con el mismo hardware utilizado por Windows 8:¿Cuáles son los requisitos del sistema de Windows 8.1 Preview?

Procesador: 1 gigahercio (GHz) o

más

RAM: 1 gigabyte (GB) (32 bits) o

2 GB (64 bits)

Espacio en disco duro: 16 GB (32

bits) o 20 GB (64 bits)

Tarjeta gráfica: dispositivo

gráfico Microsoft DirectX 9 con controlador WDDM

Windows RT 8.1 Preview requiere

que tengas un equipo que ya ejecute Windows RT con 10 GB de espacio de

almacenamiento disponible.

WINDOWS 8 VS WINDOWS 8.1

Microsoft presentó oficialmente la esperada actualización

para Windows 8 que llegará a finales de este mismo año. Windows 8.1 incorpora

algunos elementos demandados por los usuarios y otros totalmente nuevos que

buscan mejorar la experiencia de uso. A continuación veremos las principales

diferencias entre Windows 8 y Windows 8.1.

las diferencias entre Windows 8 y Windows 8.1. Muchos

afirman que Windows 8.1 es realmente lo que debió ser Windows 8 desde un

principio, tanto los usuarios que lo utilicen desde una pantalla táctil como

los que hagan uso del escritorio tradicional, agradecerán las mejoras y los

cambios que ha introducido Microsoft.

estas son las principales entre Windows 8 y Windows 8.1

- Botón de Inicio que enlaza al panel de aplicaciones

- Internet Explorer 11, el nuevo navegador por defecto

- Windows Store renovada

- Nueva aplicación para Skydrive

- Outlook 2013 disponible en Windows 8.1

- Calculadora y Alarma forman parte del sistema, no es necesario descargarlas

- Posibilidad de desinstalar varias aplicaciones al mismo tiempo

- Apagar o reiniciar con la combinación Win + X

- Nuevos tamaños de las miniaturas del panel de aplicaciones

- Nuevas funciones en la pantalla de bloqueo

- Posibilidad de configurar el fondo de escritorio como fondo de la pantalla de inicio

- Windows Defender ahora monitoriza la actividad de red

- Sincronización de pestañas entre varios dispositivos

10 de mayo de 2013

TIPOS DE REFRIGERACIÓN DE UN PC

CRIOGENIA

Incluso más raro que la refrigeración por cambio de fase es

aquella basada en la criogenia, que utiliza nitrógeno líquido o hielo seco

(dióxido de carbono sólido). Estos materiales son usados a temperaturas

extremadamente bajas (el nitrógeno líquido ebulle a los -196ºC y el hielo seco

lo hace a -78ºC) directamente sobre el procesador para mantenerlo frío. Sin

embargo, después que el líquido refrigerante se haya evaporado por completo

debe ser reemplazado. Daño al procesador a lo largo del tiempo producto de los

frecuentes cambios de temperatura es uno de los motivos por los que la

criogenia sólo es utilizada en casos extremos de overclocking y sólo por cortos

periodos de tiempo.

Claramente cada método de refrigeración tiene ventajas y

desventajas. Algunos son caros y bulliciosos, otros no lo suficientemente

poderosos, algunos requieren de instalaciones complejas e incluso existen

aquellos que pueden dañar el procesador. Buscando crear un disipador (cooler)

barato, silencioso y altamente confiable capaz de disipar efectivamente el

calor de incluso los procesadores más demandantes de gama alta, Tecnologías

Avanzadas Kronos (Kronos Advanced Technologies) dominó un principio físico

antiguo conocido como el efecto de descarga corona.

PROPULSIÓN DE AIRE

ELECTROSTÁTICO Y EL EFECTO DE DESCARGA CORONA

Un nuevo tipo de tecnología de refrigeración ultra-delgada y

silenciosa para procesadores está siendo desarrollada por Tecnologías Avanzadas

Kronos en colaboración con Intel y la Universidad de Washington. En dos años,

esta nueva tecnología podría reemplazar las actuales técnicas de enfriamiento

por ventiladores en notebooks y otros dispositivos portátiles, volviéndolos más

confiables y mucho más silenciosos.

La tecnología de refrigeración que está siendo desarrollada

por Kronos emplea un dispositivo llamado “bomba de viento iónico” (ionic wind

pump), un acelerador de fluidos electrostáticos cuyo principio básico de

operación es la descarga por efecto corona. Este fenómeno ocurre cuando el

potencial de un conductor cargado alcanza una magnitud tal que sobrepasa la

rigidez dieléctrica del fluído que lo rodea (por ejemplo aire) este aire, que

en otras circunstancias es un excelente aislante, se ioniza y los iones son

atraídos y repelidos por el conductor a gran velocidad, produciéndose una

descarga eléctrica que exhibe penachos o chispas azules o púrpura, y que a su

vez moviliza el fluido. La descarga por efecto corona es similar a lo que

ocurre con la caída de un rayo, salvo porque en ese caso no hay un conductor

propiamente tal, la diferencia de potencial eléctrico es tan enorme que los

rayos son capaces de atravesar fácilmente 5 kilómetros de aire, que por lo

general es uno de los mejores aislantes que existen.

El principio de la propulsión de aire iónico con partículas

cargadas por el efecto corona se conoce casi desde el momento en que se

descubrió la electricidad. Una de las primeras referencias a la detección de

movimiento de aire cerca de un tubo cargado apareció hace unos 300 años en un

libro de Francis Hauksbee y muchos pioneros de la electricidad, incluyendo a

Newton, Faraday y Maxwell, estudiaron este fenómeno. En los tiempos modernos la

descarga corona se utilizó de variadas maneras y se aplicó en la industria de

la fotocopia, en algunos sistemas de aire acondicionado, en lásers de nitrógeno

y más notoriamente en ionizadores de aire. Kronos, que desarrolla filtros de

aire de alta eficiencia basados en el efecto corona, intentó adaptar la

tecnología a la refrigeración de microprocesadores. Con la ayuda de N. E.

Jewell-Larsen, C.P. Hsu y A. V. Mamishev del Departamento de Ingeniería

Eléctrica (Department of Electrical Engineering) en la Universidad de

Washington (Washington University) e Intel, crearon varios prototipos

funcionales de un disipador (cooler) de CPU basado en el efecto corona, que

puede enfriar efectiva y silenciosamente una CPU moderna.

El disipador de efecto corona desarrollado por Kronos

trabaja de la siguiente manera: Un campo eléctrico de gran magnitud es creado

en la punta del cátodo, que se coloca en un lado de la CPU. El alto potencial

de energía causa que las moléculas de oxígeno y nitrógeno en el aire se ionicen

(con carga positiva) y creen una corona (un halo de partículas cargadas). Al

colocar un ánodo unido a tierra en el lado opuesto de la CPU se hace que los

iones cargados en la corona aceleren hacia el ánodo, chocando con moléculas

neutras de aire en el camino. Durante estas colisiones, se transfiere moméntum

desde el gas ionizado a las moléculas de gas neutras, resultando en un movimiento

de aire hacia el ánodo.

Las ventajas de los disipadores (coolers) basados en el

efecto de descarga corona son obvias: no tienen partes móviles, lo que elimina

ciertos problemas de confiabilidad, puede refrigerar efectivamente incluso los

procesadores más avanzados y demandantes y opera con un nivel de ruido de

prácticamente cero con un consumo moderado de energía

CAMBIO DE FASE POR VIBRACIÓN

El Vibration Induced Droplet Atomization (VIDA) es un

sistema experimental que probablemente nunca se utilizará comercialmente pero

por lo ingenioso que resulta vale la pena mencionarlo. En rigor, dudé mucho si

ubicarlo como un subconjunto de los sistemas de cambio de fase porque el

principio de su funcionamiento no se basa en el ciclo térmico que inventó

Carnot, pero de todos modos el fenómeno físico mediante el cual se retira calor

es en buenas cuentas un cambio de fase.

El VIDA opera de la siguiente manera: atomizando un fluido

que puede ser simplemente agua, y sometiéndolo a una intensa vibración, se

logra que éste pase al estado gaseoso a temperatura ambiente. Al evaporarse, el

agua (o el líquido que se utilice) toma una gran cantidad de calor del medio

circundante. En otras palabras, una gótula de agua lo suficientemente pequeña y

convenientemente zangoloteada se convertirá en vapor espontáneamente, y si

logras que ello ocurra en contacto con la superficie deseada, el agua retirará

de ella una gran cantidad de calor.

El sistema VIDA fué planteado por primera vez en marzo del

2005 y te lo contamos en esta noticia.

CAMBIO DE FASE

Los sistemas de enfriamiento por

cambio de fase se basan en la misma máquina térmica que opera en todo

refrigerador. Aunque los sistemas han cambiado mucho desde los primeros

refrigeradores -empezando por el abandono de los gases que eran dañinos para el

medio ambiente- el principio es el mismo: utilizar a nuestro favor la ley de

los gases perfectos y las propiedades termodinámicas de un gas para instigarlo

a tomar o ceder calor del o al medio ambiente en distintos puntos del ciclo.

El cambio de fase es el método de

enfriamiento preferido en refrigeradores comerciales y algunos sistemas de aire

acondicionado, pero en el campo de la computación se ve muy poco. En un primer

acercamiento algunos técnicos en refrigeración aficionados al overclock

implementaron máquinas artesanales para aplicar refrigeración por cambio de

fase al PC, pero en los últimos años se viene viendo de forma cada vez más

frecuente la aparición de sistemas comerciales, más compactos, estilizados y

-por supuesto- caros.

Los overclockeros extremos no

miran con muy buenos ojos estas soluciones comerciales principalmente por dos

razones. Primero, las necesidades de enfriamiento de cada plataforma son

distintas, y aunque es improbable que el PC vaya a calentarse utilizando un

sistema de cambio de fase, sí puede darse que la solución comercial sea

insuficiente para llegar a temperaturas extremadamente bajas. En segundo lugar,

hoy por hoy el ciclo clásico que se ilustra en el esquema ha sido refinado y

paulatinamente reemplazado por circuitos en cascada, en donde hay varios ciclos

de refrigeración por cambio de fase y cada uno enfría al siguiente.

REFRIGERACIÓN POR HEATPIPES

Un heatpipe es una máquina

térmica que funciona mediante un fenómeno llamado "convección

natural". Este fenómeno, derivado de la expansión volumétrica de los fluidos,

causa que al calentarse los fluidos tiendan a hacerse menos densos, y

viceversa. En un mismo recipiente, el calentamiento de la base producirá la

subida del fluido caliente de abajo y la bajada del fluido aún frío de la parte

superior, produciéndose una circulación.

El sistema de heatpipes que se

utiliza en los coolers de CPU es un ciclo cerrado en donde un fluído similar al

que recorre nuestros refrigeradores se calienta en la base, en contacto con el

CPU, se evapora, sube por una tubería hasta el disipador, se condensa y baja

como líquido a la base nuevamente.

El transporte de calor que se

logra mediante el uso de heatpipes es muy superior al que alcanza un disipador

de metal tradicional, por delgadas o numerosas que sean sus aletas. Sin

embargo, sería poco ambicioso dejar que los heatpipes hicieran todo el trabajo,

por lo que los productos comerciales que han incorporado el elemento heatpipe

complementan su alta capacidad de transporte de calor con voluminosos panales

de aluminio o cobre (en buenas cuentas, un heatsink) y ventiladores que mueven

bastante caudal de aire.

REFRIGERACIÓN TERMOELÉCTRICA (TEC)

En 1834 un

frances llamado Juan Peltier (no es chiste, la traducción al español de Jean

Peltier), descubrió que aplicando una diferencia eléctrica en 2 metales o

semiconductores (de tipo p y n) unidas entre sí, se generaba una diferencia de

temperaturas entre las uniones de estos. La figura de abajo muestra que las

uniones p-n tienden a calentarse y las n-p a enfriarse.

El concepto

rudimentario de Peltier fue paulatinamente perfeccionado para que fuera un solo

bloque con las uniones semiconductoras, (que generalmente son en base a

Seleniuro de Antimonio y Telururo de bismuto) conectadas por pistas de cobre y

dispuestas de tal manera, que transportara el calor desde una de sus caras

hacia la otra, haciendo del mecanismo una "bomba de calor" ya que es

capaz de extraer el calor de una determinada superficie y llevarlo hacia su

otra cara para disiparlo.

Una de las tantas

gracias de estos sistemas de refrigeración que se ocupan en todo ámbito

(generalmente industrial), es que son bastante versátiles, basta con invertir

la polaridad para invertir el efecto (cambiar el lado que se calienta por el

frío y viceversa), la potencia con que enfría es fácilmente modificable

dependiendo del voltaje que se le aplique y es bastante amable con el medio

ambiente ya que no necesita de gases nocivos como los usados en los

refrigeradores industriales para realizar su labor.

El uso de

refrigeración termoeléctrica por lo general se circunscribe al ámbito

industrial, pero tanto los fanáticos como algunos fabricantes han desarrollado

productos que incorporan el elemento Peltier como método para enfriar el

procesador de un PC. Estas soluciones, que de por sí involucran un fuerte

aumento del consumo eléctrico (toda vez que un peltier es bastante demandante

de potencia) no pueden operar por sí solas, pues se hace necesario un sistema

que sea capaz de retirar calor de la cara caliente del Peltier.

Este sistema

complementario suele ser de enfriamiento por aire o por agua. En el primero de

los casos el concepto se denomina Air Chiller y hay productos comerciales como

el Titan Amanda que lo implementan. El segundo caso se denomina Water Chiller,

es bastante más efectivo (por la mejor capacidad del agua de retirar calor de

la cara caliente) y también hay productos, como el Coolit Freezone, que

implementan el sistema.

REFRIGERACIÓN POR METAL LÍQUIDO

Aunque su principio es

completamente distinto al watercooling, de alguna manera este sistema está

emparentado. Se trata de un invento mostrado por nanoCoolers, compañía basada

en Austin, Texas, que hace algunos años desarrolló un sistema de enfriamiento

basado en un metal líquido con una conductividad térmica mayor que la del agua,

constituido principalmente por Galio e Indio.

A diferencia del agua, este

compuesto puede ser bombeado electromagnéticamente, eliminando la necesidad de

una bomba mecánica. A pesar de su naturaleza innovadora, el metal líquido de

nanoCoolers nunca alcanzó una etapa comercial.

Una explicación bastante extensa

y en español puede encontrarse en Hardcore Modding.

REFRIGERACIÓN LIQUIDA POR INMERSIÓN

Una variación extraña de este mecanismo de refrigeración es

la inmersión líquida, en la que un computador es totalmente sumergido en un

líquido de conductividad eléctrica muy baja, como el aceite mineral. El

computador se mantiene enfriado por el intercambio de calor entre sus partes,

el líquido refrigerante y el aire del ambiente. Este método no es práctico para

la mayoría de los usuarios por razones obvias.

Pese a que este método tiene un enfoque bastante simple

(llene un acuario de aceite mineral y luego ponga su PC adentro) también tiene

sus desventajas. Para empezar, debe ser bastante desagradable el intercambio de

piezas para upgrade.

REFRIGERACIÓN LÍQUIDA (MÁS CONOCIDA COMO WATERCOOLING)

Un método más complejo y menos común es la refrigeración por agua. El agua tiene un calor específico más alto y una mejor conductividad térmica que el aire, gracias a lo cual puede transferir calor más eficientemente y a mayores distancias que el gas. Bombeando agua alrededor de un procesador es posible remover grandes cantidades de calor de éste en poco tiempo, para luego ser disipado por un radiador ubicado en algún lugar dentro (o fuera) del computador. La principal ventaja de la refrigeración líquida, es su habilidad para enfriar incluso los componentes más calientes de un computador.

Todo lo bueno del watercooling tiene, sin embargo, un precio; la refrigeración por agua es cara, compleja e incluso peligrosa en manos sin experiencia (Puesto que el agua y los componentes electrónicos no son buena pareja). Aunque usualmente menos ruidosos que los basados en refrigeración por aire, los sistemas de refrigeración por agua tienen partes móviles y en consecuencia se sabe eventualmente pueden sufrir problemas de confiabilidad. Sin embargo, una avería en un sistema de Watercooling (por ejemplo, si deja de funcionar la bomba) no es tan grave como en el caso de la refrigeración por aire, puesto que la inercia térmica del fluído es bastante alta e incluso encontrándose estático no será fácil para el CPU calentarlo a niveles peligrosos

REFRIGERACIÓN ACTIVA POR AIRE

La refrigeración activa por aire es,

en palabras sencillas, tomar un sistema pasivo y adicionar un elemento que

acelere el flujo de aire a través de las aletas del heatsink. Este elemento es

usualmente un ventilador aunque se han visto variantes en las que se utiliza

una especie de turbina.

En la refrigeración pasiva tiende a

suceder que el aire que rodea al disipador se calienta, y su capacidad de

evacuar calor del disipador disminuye. Aunque por convección natural este aire

caliente se mueve, es mucho más eficiente incorporar un mecanismo para forzar

un flujo de aire fresco a través de las aletas del disipador, y es exactamente

lo que se logra con la refrigeración activa.

Aunque la refrigeración activa por

aire no es mucho más cara que la pasiva, la solución tiene desventajas

significativas. Por ejemplo, al tener partes móviles es susceptible de

averiarse, pudiendo ocasionar daños irreparables en el sistema si es que esta

avería no se detecta a tiempo (en otras palabras, si un sistema pensado para

ser enfriado activamente queda en estado pasivo por mucho tiempo). En segundo

lugar, aunque este aspecto ha mejorado mucho todos los ventiladores hacen

ruido. Algunos son más silenciosos que otros, pero siempre serán más ruidosos

que los cero decibeles que produce una solución pasiva.

REFRIGERACIÓN PASIVA

POR AIRE

Las principales ventajas de la

disipación pasiva son su inherente simplicidad (pues se trata básicamente de un

gran pedazo de metal), su durabilidad (pues carece de piezas móviles) y su bajo

costo. Además de lo anterior, no producen ruido. La mayor desventaja de la

disipación pasiva es su habilidad limitada para dispersar grandes cantidades de

calor rápidamente. Los disipadores (heatsinks) modernos son incapaces de

refrigerar efectivamente CPUs de gama alta, sin mencionar GPUs de la misma

categoría sin ayuda de un ventilador.

Los disipadores (heatsinks)

modernos son usualmente fabricados en cobre o aluminio, materiales que son

excelentes conductores de calor y que son relativamente baratos de producir. En

particular, el cobre es bastante más caro que el aluminio por lo que los

disipadores de cobre se consideran el formato premium mientras que los de

aluminio son lo estándar. Sin embargo, si de verdad quisiéramos conductores

premium podríamos usar plata para este fin, puesto que su conductividad térmica

es mayor todavía. Por eso, aunque el cobre es sustancialmente más caro que el

aluminio, es válido decir que ambos son materiales baratos... sólo piensen en

la alternativa.

REFRIGERACIÓN POR

AIRE

La refrigeración pasiva es

probablemente el método más antiguo y común para enfriar no sólo componentes

electrónicos sino cualquier cosa. Así como dicen las abuelitas: "tomar el

fresco", la idea es que ocurra intercambio de calor entre el aire a

temperatura ambiente y el elemento a enfriar, a temperatura mayor. El sistema

es tan común que no es en modo alguna invención del hombre y la misma

naturaleza lo emplea profusamente: miren por ejemplo a los elefantes que usan

sus enormes orejas para mantenerse frescos, y no porque las usen de abanico

sino porque éstas están llenas de capilares y el aire fresco enfría la sangre

que por ellos circula.

El ejemplo de los elefantes se

aplica, entonces, a las técnicas para enfriar componentes electrónicos, y la

idea es básicamente la misma: incrementar la superficie de contacto con el aire

para maximizar el calor que éste es capaz de retirar. Justamente con el objeto

de maximizar la superficie de contacto, los disipadores o en inglés heatsinks

consisten en cientos de aletas delgadas. Mientras más aletas, más disipación.

Mientras más delgadas, mejor todavía.

7 de mayo de 2013

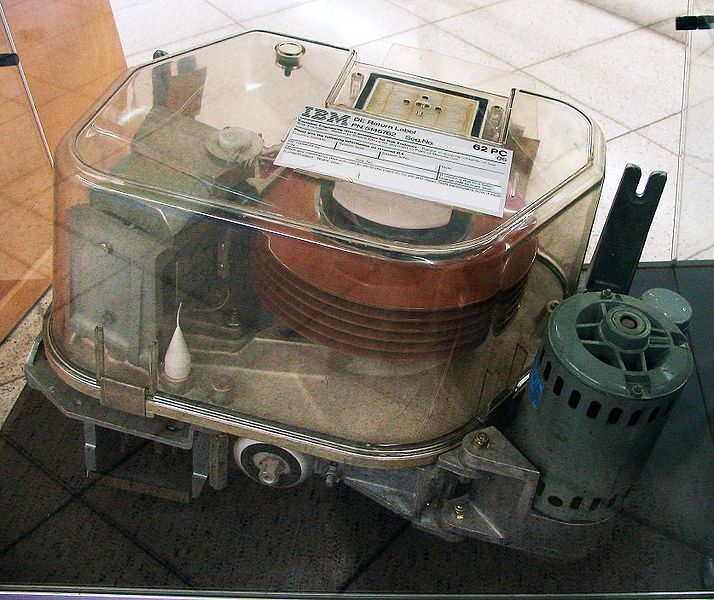

DISCO DURO IBM 350

El IBM 350 era parte del IBM 305 RAMAC, la computadora que introdujo al mundo la tecnología de almacenamiento en discos, el 4 de septiembre de 1956. RAMAC "Random Access Method of Accounting and Control". Su diseño fue motivado por la necesidad de sustituir las tarjetas perforadas usadas por la mayoría de los negocios de la época. Los IBM 350 podían almacenar 5 millones de caracteres de 7 bit (cerca de 4,4 megabytes). Tenían cincuenta discos de 61 cm (24 pulgadas) de diámetro con 100 superficies de grabación. Cada superficie tenía 100 pistas. Los discos giraban a 1200 RPM. La tasa de transferencia de datos era de 8800 caracteres por segundo. Dos cabezales de acceso independientes se movían hacia arriba y hacia abajo para seleccionar un disco y adentro y hacia fuera para seleccionar una pista de grabación, todo esto controlado por un servo. Se agregó un tercer cabezal opcional. En los años 50se añadieron varios modelos mejorados. La computadora IBM RAMAC 305 con el disco de almacenamiento IBM 350 se podía alquilar por unos 3200 dólares al mes. Los IBM 350 fueron retirados oficialmente en 1969.

Las dimensiones del IBM 350 eran 1,52 metros de largo, 1,73 metros de alto y 74 cm ancho. IBM tenía una regla terminante, que todos sus productos no deben sobrepasar el estándar de 75 cm (29,5 pulgadas). Puesto que los IBM 350 fueron montados horizontalmente, esta regla dictó probablemente el diámetro máximo de los discos

En una entrevista publicada en el Wall Street Journal a Currie Munce, el vice presidente de investigación de Hitachi Global Storage Technologies, que adquirieron el negocio del almacenaje de IBM, dijo que la unidad entera de RAMAC pesaba mas de una tonelada y tuvo que ser trasladada con montacargas y ser entregada usando grandes aviones de carga. Según Munce, mientras que la capacidad de almacenamiento podía ser aumentada a unos 5 megabytes, el departamento de marketing de IBM estaba en contra del aumento de la capacidad porque no sabían vender un producto con más almacenaje.

Hoy en día, el Museo de historia de la computadora, situado en Mountain View, California, dispone de una restauración del disco de almacenamiento del RAMAC.

A principios los discos duros eran extraíbles, sin embargo, hoy en día típicamente vienen todos sellados (a excepción, de un hueco de ventilación para filtrar e igualar la presión del aire).

El primer disco duro 1956 fue el IBM 350 modelo 1, presentado con la computadora Ramac I: pesaba una tonelada y su capacidad era de 5 MB. Más grande que una nevera actual, este disco duro trabajaba todavía con válvulas al vacío y requería una consola separada para su manejo.

Su gran mérito consistía en el que el tiempo requerido para el acceso era relativamente diferente entre algunas posiciones de memoria, a diferencia de las cintas magnéticas, donde para encontrar una información dada, era necesario enrollar y desenrollar los carretes hasta encontrar el dato buscado, teniendo muy diferentes tiempos de acceso para cada posición.

La tecnología inicial aplicada a los discos duros era relativamente simple. Consistía en recubrir con material magnético un disco de metal que era formateado en pistas concéntricas, que luego eran divididas en sectores. El cabezal magnético codificaba información al magnetizar diminutas secciones del disco duro, empleando un código binario de «ceros» y «unos». Los bits o dígitos binarios así grabados pueden permanecer intactos años. Originalmente, cada bit tenía una disposición horizontal en la superficie magnética del disco, pero luego se descubrió cómo registrar la información de una manera más compacta.

El mérito del francés Albert Fert y al alemán Peter Grünberg (ambos premio Nobel de Física, por sus contribuciones en el campo del almacenamiento magnético) fue el descubrimiento del fenómeno conocido como magnetorresistencia gigante, permitió construir cabezales de lectura y grabación más sensibles, y compactar más los bits en la superficie del disco duro. De estos descubrimientos, realizados en forma independiente por estos investigadores, se desprendió un crecimiento espectacular en la capacidad de almacenamiento en los discos duros, que se elevó un 60% anual en la década de 1990.

En 1992, los discos duros de 3,5 pulgadas alojaban 250 MB, mientras que 10 años después habían superado los 40.000 MB o 40 gigabytes (GB). En la actualidad, ya contamos en el uso cotidiano con discos duros de más de un terabyte (TB) o millón de megabytes.

En 2005 los primeros teléfonos móviles que incluían discos duros fueron presentados por Samsung y Nokia.

Características de un disco duro

Las características que se deben tener en cuenta en un disco duro son:

• Tiempo medio de acceso: Tiempo medio que tarda la aguja en situarse en la pista y el sector deseado; es la suma del Tiempo medio de búsqueda (situarse en la pista), tiempo de lectura/escritura y la Latencia media (situarse en el sector).

• Tiempo medio de búsqueda: Tiempo medio que tarda la aguja en situarse en la pista deseada; es la mitad del tiempo empleado por la aguja en ir desde la pista más periférica hasta la más central del disco.

• Tiempo de lectura/escritura: Tiempo medio que tarda el disco en leer o escribir nueva información, el tiempo depende de la cantidad de información que se quiere leer o escribir, el tamaño de bloque, el numero de cabezales, el tiempo por vuelta y la cantidad de sectores por pista.

• Latencia media: Tiempo medio que tarda la aguja en situarse en el sector deseado; es la mitad del tiempo empleado en una rotación completa del disco.

• Velocidad de rotación: Revoluciones por minuto de los platos. A mayor velocidad de rotación, menor latencia media.

• Tasa de transferencia: Velocidad a la que puede transferir la información a la computadora una vez la aguja esta situada en la pista y sector correctos. Puede ser velocidad sostenida o de pico.

• COMO FUNCIONA UN DISCO DURO.

• 1. Una caja metálica hermética protege los componentes internos de las partículas de polvo; que podrían obstruir la estrecha separación entre las cabezas de lectura/escritura y los discos, además de provocar el fallo de la unidad a causa de la apertura de un surco en el revestimiento magnético de un disco. 2. En la parte inferior de la unidad, una placa de circuito impreso, conocida también como placa lógica, recibe comandos del controlador de la unidad, que a su vez es controlado por el sistema operativo. La placa lógica convierte estos comandos en fluctuaciones de tensión que obligan al actuador de las cabezas a mover estas a lo largo de las superficies de los discos. La placa también se asegura de que el eje giratorio que mueve los discos de vueltas a una velocidad constante y de que la placa le indique a las cabezas de la unidad en que momento deben leer y escribir en el disco. En un disco IDE (Electrónica de Unidades Integradas), el controlador de disco forma parte de la placa lógica. 3. Un eje giratorio o rotor conectado a un motor eléctrico hacen que los discos revestidos magnéticamente giren a varios miles de vueltas por minuto. El número de discos y la composición del material magnético que lo s recubre determinan la capacidad de la unidad. Generalmente los discos actuales están recubiertos de una aleación de aproximadamente la trimillonésima parte del grosor de una pulgada. 4. Un actuador de las cabezas empuja y tira del grupo de brazos de las cabezas de lectura/escritura a lo largo de las superficies de los platos con suma precisión. Alinea las cabezas con las pistas que forman círculos concéntricos sobre la superficie de los discos. 5. Las cabezas de lectura/escritura unidas a los extremos de los brazos móviles se deslizan a la vez a lo largo de las superficies de los discos giratorios del HD. Las cabezas escriben en los discos los datos procedentes del controlador de disco alineando las partículas magnéticas sobre las superficies de los discos; las cabezas leen los datos mediante la detección de las polaridades de las partículas ya alineadas. 6. Cuando el usuario o su software le indican al sistema operativo que lea o escriba un archivo, el sistema operativo ordena al controlador del HD que mueva las cabezas de lectura y escritura a la tabla de asignación de archivos de la unidad, o FAT en DOS (VFAT en Windows 95). El sistema operativo lee la FAT para determinar en que Cluster del disco comienza un archivo preexistente, o que zonas del disco están disponibles para albergar un nuevo archivo. 7. Un único archivo puede diseminarse entre cientos de Cluster independientes dispersos a lo largo de varios discos. El sistema operativo almacena el comienzo de un archivo en los primeros Cluster que encuentra enumerados como libres en la FAT. Esta mantiene un registro encadenado de los Cluster utilizados por un archivo y cada enlace de la cadena conduce al siguiente Cluster que contiene otra parte mas del archivo. Una vez que los datos de la FAT han pasado de nuevo al sistema operativo a través del sistema electrónico de la unidad y del controlador del HD, el sistema operativo da instrucciones a la unidad para que omita la operación de las cabezas de lectura/escritura a lo largo de la superficie de los discos, leyendo o escribiendo los Cluster sobre los discos que giran después de las cabezas. Después de escribir un nuevo archivo en el disco, el sistema operativo vuelve a enviar las cabezas de lectura/escritura a la FAT, donde elabora una lista de todos los Cluster del archivo.

Disco duro

En informática, un disco duro o disco rígido

(en inglés Hard Disk Drive, HDD) es un dispositivo de almacenamiento de datos

no volátil que emplea un sistema de grabación magnética para almacenar datos

digitales. Se compone de uno o más platos o discos rígidos, unidos por un mismo

eje que gira a gran velocidad dentro de una caja metálica sellada. Sobre cada

plato, y en cada una de sus caras, se sitúa un cabezal de lectura/escritura que

flota sobre una delgada lámina de aire generada por la rotación de los discos.

El primer disco duro fue inventado por IBM en

1956. A lo largo de los años, los discos duros han disminuido su precio al

mismo tiempo que han multiplicado su capacidad, siendo la principal opción de

almacenamiento secundario para PC desde su aparición en los años 1960.1 Los

discos duros han mantenido su posición dominante gracias a los constantes

incrementos en la densidad de grabación, que se ha mantenido a la par de las

necesidades de almacenamiento secundario.

Los tamaños también han variado mucho, desde

los primeros discos IBM hasta los formatos estandarizados actualmente: 3,5

" los modelos para PC y servidores, 2,5 " los modelos para

dispositivos portátiles. Todos se comunican con la computadora a través del

controlador de disco, empleando una interfaz estandarizada. Los más comunes

hasta los años 2000 han sido IDE (también llamado ATA o PATA), SCSI

(generalmente usado en servidores y estaciones de trabajo). Desde el 2000 en

adelante ha ido masificándose el uso de los Serial ATA. Existe además FC (empleado

exclusivamente en servidores).

Para poder utilizar un disco duro, un sistema

operativo debe aplicar un formato de bajo nivel que defina una o más

particiones. La operación de formateo requiere el uso de una fracción del

espacio disponible en el disco, que dependerá del formato empleado. Además, los

fabricantes de discos duros, unidades de estado sólido y tarjetas flash miden

la capacidad de los mismos usando prefijos SI, que emplean múltiplos de

potencias de 1000 según la normativa IEC yIEEE, en lugar de los prefijos

binarios, que emplean múltiplos de potencias de 1024, y son los usados por

sistemas operativos de Microsoft. Esto provoca que en algunos sistemas

operativos sea representado como múltiplos 1024 o como 1000, y por tanto

existan confusiones, por ejemplo un disco duro de 500 GB, en algunos sistemas

operativos sea representado como 465 GiB (es decir gibibytes; 1 GiB = 1024 MiB)

y en otros como 500 GB.

Las unidades de estado sólido tienen el mismo

uso que los discos duros y emplean las mismas interfaces, pero no están

formadas por discos mecánicos, sino por memorias de circuitos integrados para

almacenar la información. El uso de esta clase de dispositivos anteriormente se

limitaba a las supercomputadoras, por su elevado precio, aunque hoy en día ya

son muchísimo más asequibles para el mercado doméstico.

En informática, un disco duro o disco rígido

(en inglés Hard Disk Drive, HDD) es un dispositivo de almacenamiento de datos

no volátil que emplea un sistema de grabación magnética para almacenar datos

digitales. Se compone de uno o más platos o discos rígidos, unidos por un mismo

eje que gira a gran velocidad dentro de una caja metálica sellada. Sobre cada

plato, y en cada una de sus caras, se sitúa un cabezal de lectura/escritura que

flota sobre una delgada lámina de aire generada por la rotación de los discos.

El primer disco duro fue inventado por IBM en

1956. A lo largo de los años, los discos duros han disminuido su precio al

mismo tiempo que han multiplicado su capacidad, siendo la principal opción de

almacenamiento secundario para PC desde su aparición en los años 1960.1 Los

discos duros han mantenido su posición dominante gracias a los constantes

incrementos en la densidad de grabación, que se ha mantenido a la par de las

necesidades de almacenamiento secundario.

Los tamaños también han variado mucho, desde

los primeros discos IBM hasta los formatos estandarizados actualmente: 3,5

" los modelos para PC y servidores, 2,5 " los modelos para

dispositivos portátiles. Todos se comunican con la computadora a través del

controlador de disco, empleando una interfaz estandarizada. Los más comunes

hasta los años 2000 han sido IDE (también llamado ATA o PATA), SCSI

(generalmente usado en servidores y estaciones de trabajo). Desde el 2000 en

adelante ha ido masificándose el uso de los Serial ATA. Existe además FC (empleado

exclusivamente en servidores).

Para poder utilizar un disco duro, un sistema

operativo debe aplicar un formato de bajo nivel que defina una o más

particiones. La operación de formateo requiere el uso de una fracción del

espacio disponible en el disco, que dependerá del formato empleado. Además, los

fabricantes de discos duros, unidades de estado sólido y tarjetas flash miden

la capacidad de los mismos usando prefijos SI, que emplean múltiplos de

potencias de 1000 según la normativa IEC yIEEE, en lugar de los prefijos

binarios, que emplean múltiplos de potencias de 1024, y son los usados por

sistemas operativos de Microsoft. Esto provoca que en algunos sistemas

operativos sea representado como múltiplos 1024 o como 1000, y por tanto

existan confusiones, por ejemplo un disco duro de 500 GB, en algunos sistemas

operativos sea representado como 465 GiB (es decir gibibytes; 1 GiB = 1024 MiB)

y en otros como 500 GB.

Las unidades de estado sólido tienen el mismo

uso que los discos duros y emplean las mismas interfaces, pero no están

formadas por discos mecánicos, sino por memorias de circuitos integrados para

almacenar la información. El uso de esta clase de dispositivos anteriormente se

limitaba a las supercomputadoras, por su elevado precio, aunque hoy en día ya

son muchísimo más asequibles para el mercado doméstico.

1 de mayo de 2013

MANTENIMIENTO CORRECTIVO

Dentro de las operaciones de mantenimiento, se denomina mantenimiento correctivo, a aquel que corrige los defectos observados en los equipamientos o instalaciones, es la forma más básica de mantenimiento y consiste en localizar averías o defectos y corregirlos o repararlos.

Históricamente es el primer concepto de mantenimiento que se planteo, y el único hasta la primera guerra mundial, dada la simplicidad de las maquinas, equipamientos e instalaciones de la época, mantenimiento era sinónimo de reparar aquello que estaba averiado. Posteriormente se planteo que el mantenimiento no solo tenia que corregir las averías, sino que tenia que adelantarse a ellas garantizando el correcto funcionamiento de las maquinas, evitando el retraso producido por las averías y sus consecuencia, dando lugar a lo que se denomino: mantenimiento preventivo que es el que se hace, preventivamente en equipo en funcionamiento, en evicción de posteriores averías, garantizando un periodo de uso fiable.

MANTENIMIENTO PREVENTIVO

En las operaciones de mantenimiento, el mantenimiento preventivo es el destinado a la conservación de equipos o instalaciones mediante realización de revisión y reparación que garanticen su buen funcionamiento y fiabilidad. El mantenimiento preventivo se realiza en equipos en condiciones de funcionamiento, por oposición al mantenimiento correctivo que repara o pone en condiciones de funcionamiento aquellos que dejaron de funcionar o están dañados.

El primer objetivo del mantenimiento es evitar o mitigar las consecuencias de los fallos del equipo, logrando prevenir las incidencias antes de que estas ocurran. Las tareas de mantenimiento preventivo incluyen acciones como cambio de piezas desgastadas, cambios de aceites y lubricantes, etc. El mantenimiento preventivo debe evitar los fallos en el equipo antes de que estos ocurran.

Algunos de los métodos más habituales para determinar que procesos de mantenimiento preventivo deben llevarse a cabo son las recomendaciones de los fabricantes, la legislación vigente, las recomendaciones de expertos y las acciones llevadas a cabo sobre activos similares.

En informática

Relativo a la informática, el mantenimiento preventivo consiste en la revisión de equipos en funcionamiento para garantizar su buen funcionamiento, tanto de hardware como de software en un ordenador. Estos influyen en el desempeño fiable del sistema, en la integridad de los datos almacenados y en un intercambio de información correcta, a la máxima velocidad posible dentro de la configuración óptima del sistema.

Dentro del mantenimiento preventivo existe software que permite al usuario vigilar constantemente el estado de su equipo, así como también realizar pequeños ajustes de una manera fácil.

Además debemos agregar que el mantenimiento preventivo en general se ocupa en la determinación de condiciones operativas, de durabilidad y fiabilidad de un equipo en mención este tipo de mantenimiento nos ayuda en reducir los tiempos de parada que pueden generarse por mantenimiento correctivo.

En lo referente al mantenimiento preventivo de un producto software, se diferencia del resto de tipos de mantenimiento, especialmente del mantenimiento de actualización, que se produce generalmente tras una petición de cambio por parte del cliente o del usuario final o tras un estudio de posibilidades de mejora en los diferentes módulos del sistema, el preventivo se produce para garantizar el funcionamiento en las condiciones actuales de prestaciones, seguridad y fiabilidad.

Aunque el mantenimiento preventivo es considerado valioso para las organizaciones, existen una serie de fallas en la maquinaria o errores humanos: averías, mal uso, etc. que son impredecibles a la hora de realizar estos procesos de mantenimiento.

El mantenimiento preventivo programado y la sustitución planificada de equipos son dos de las tres políticas disponibles para los ingenieros de mantenimiento

Suscribirse a:

Comentarios (Atom)